精彩评论

- 张麻子是杂种(2个月前 (12-09))

从有人以来就没有比张麻子更邪恶 张口闭口为人民,害死几千万人还为人民,为自己的皇位还差不多,...

评:深度解析《让子弹飞》 al2359(3年前 (2023-02-06))

求科学离线插件,谢谢!34401355@qq.com

评:改版梅林固件安装SS【shadowsocks】科学上网插件教程al2359(3年前 (2023-02-06))

求科学离线插件,谢谢!!!

评:改版梅林固件安装SS【shadowsocks】科学上网插件教程

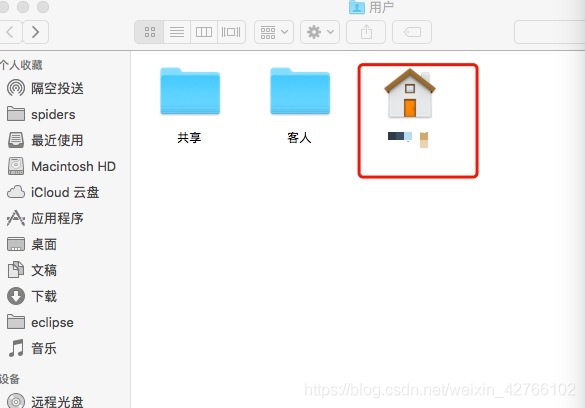

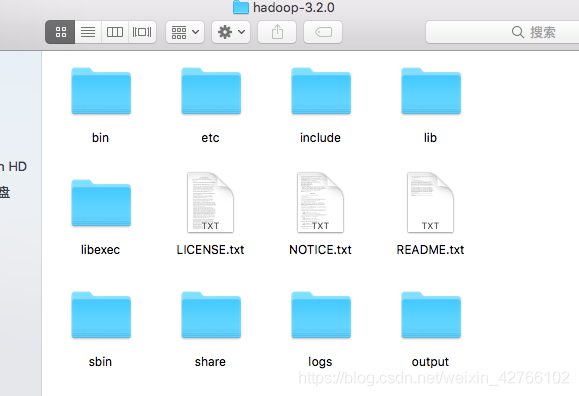

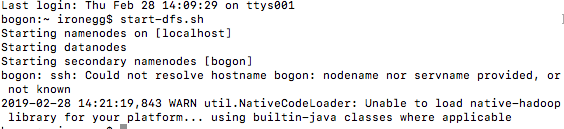

最折腾的步骤是在hadoop的安装,我尝试安装了4次,前两次直接用brew install hadoop+其他博客上的安装教程,后面两次直接按照hadoop官网说的安,第三次是因为我安装在/usr/local下面遇到了用户权限的问题才又重新安装了一遍。所以说按照hadoop官网安装是最保险的。下面的介绍都是基于hadoop官网的教程,需要配合官网教程食用~

/usr/libexec/java_home

bin/hadoop

官网提供了3种安装模式我选的是第二种伪分布式。

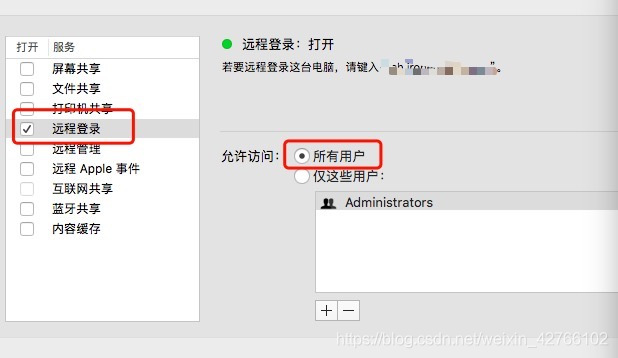

ssh localhost

$ bin/hdfs namenode -format

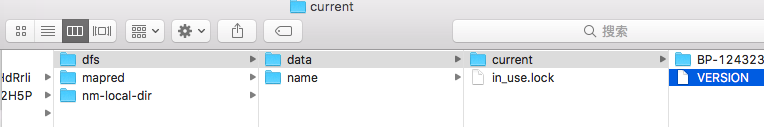

这里要千万要注意的是只能格式化一次,要是重复格式化的话会导致namenode的cluster id和datanode的cluster id不一致然后你就得去改id,但我改了没有效果所以就删档重来。

sbin/start-dfs.sh

到了这里你就能リンクスタート了,后面没有坑,照着官网一步一步走,在Execution的6. Run some of the examples provided:

$ bin/hadoop jar share/hadoop/mapreduce/hadoop-mapreduce-examples-2.9.2.jar grep input output 'dfs[a-z.]+'

记得把2.9.2换成你自己的hadoop版本就可以运行的。

把data的那个version里面的clusterid改成跟name下面的clusterid一致;但我尝试过了没反应,可能是我自己哪里又犯错了趴。。

把data的那个version里面的clusterid改成跟name下面的clusterid一致;但我尝试过了没反应,可能是我自己哪里又犯错了趴。。打开.bash_profile文件,添加

配置环境变量的时候不要抄!!记得对照你自己的文件路径!!

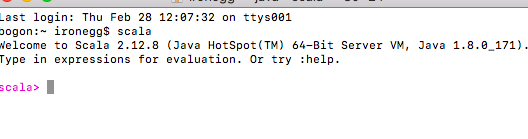

叮~成功的~

直接brew install scala

官网 http://spark.apache.org/downloads.html

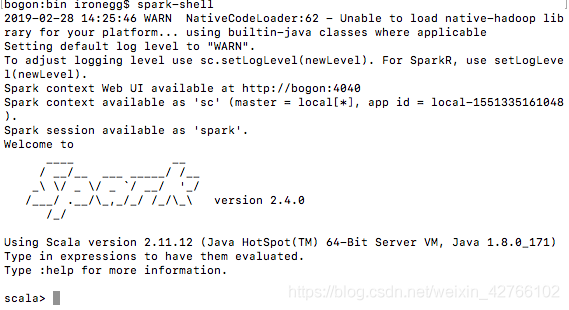

我安装的是spark-2.4.0-bin-hadoop2.7.tar,解压后把他放在跟hadoop同一文件夹中。

环境变量在上面一起配置好了,mac自带了python2所以要添加个pyspark_python的路径(跟上面的环境变量配置一起了),这样pyspark才能基于python3调用。

终端输入spark-shell调出spark

那个WARN NativeCodeLoader:62网上有解决办法可以自行查找虽然我还没去看。

「梦想一旦被付诸行动,就会变得神圣,如果觉得我的文章对您有用,请帮助本站成长」

上一篇:使用 Shell 脚本自动化 Linux 系统维护任务

从有人以来就没有比张麻子更邪恶 张口闭口为人民,害死几千万人还为人民,为自己的皇位还差不多,...

评:深度解析《让子弹飞》求科学离线插件,谢谢!34401355@qq.com

评:改版梅林固件安装SS【shadowsocks】科学上网插件教程求科学离线插件,谢谢!!!

评:改版梅林固件安装SS【shadowsocks】科学上网插件教程