精彩评论

- 张麻子是杂种(3个月前 (12-09))

从有人以来就没有比张麻子更邪恶 张口闭口为人民,害死几千万人还为人民,为自己的皇位还差不多,...

评:深度解析《让子弹飞》 al2359(3年前 (2023-02-06))

求科学离线插件,谢谢!34401355@qq.com

评:改版梅林固件安装SS【shadowsocks】科学上网插件教程al2359(3年前 (2023-02-06))

求科学离线插件,谢谢!!!

评:改版梅林固件安装SS【shadowsocks】科学上网插件教程

{/* 封面图片 */}

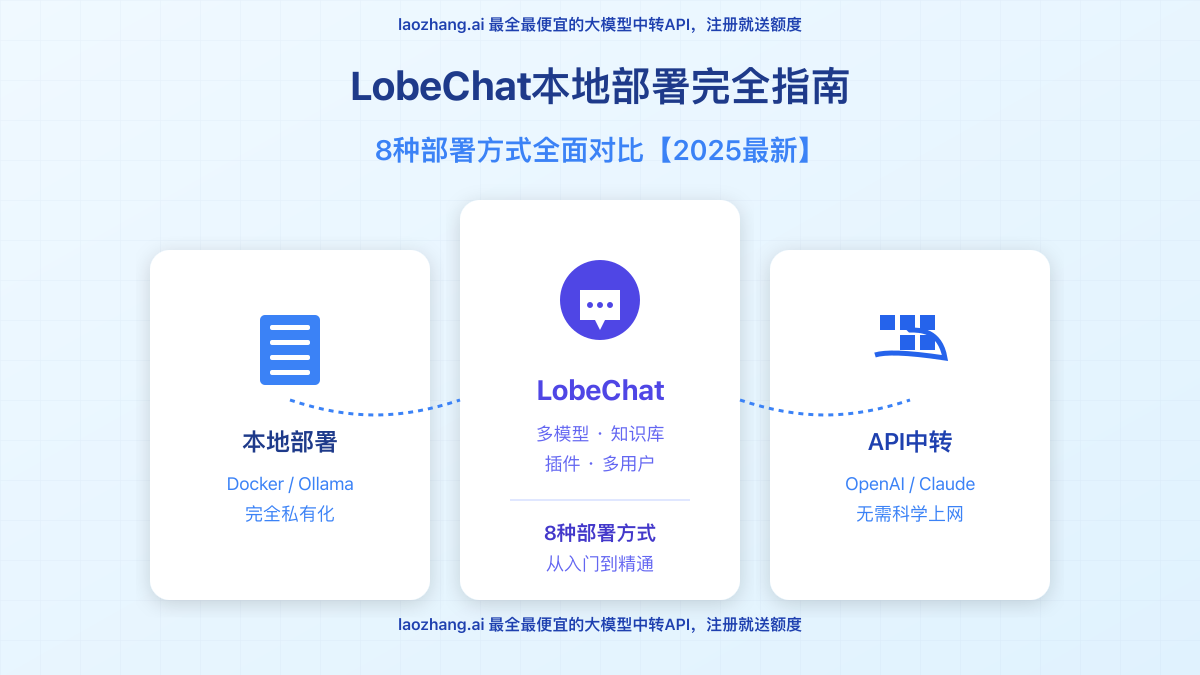

作为AI爱好者和开发者,拥有一个完全由自己控制的AI聊天平台是很多人的需求。LobeChat作为一款开源的、功能强大的AI聊天应用,支持多模型接入、知识库管理和插件扩展,已成为国内外开发者首选的自部署AI平台。然而,面对不同的部署方式和配置选项,很多用户往往感到困惑:该选择哪种部署模式?如何保证数据安全?怎样让多人共享访问?

? 2025年1月实测有效:本文提供8种专业部署方案,从0基础小白到专业开发者都能找到适合自己的部署方式,最快20分钟即可完成搭建!并支持多种大模型接入,包括本地模型和云端API!

在开始部署教程前,我们需要理解为什么LobeChat的本地部署方案如此受欢迎。经过深入分析和实测,它的核心优势主要体现在以下几个方面:

LobeChat本地部署最大的优势在于数据隐私保护。所有的聊天记录、提示词和敏感信息全部存储在你自己的设备或服务器上,不会被第三方收集或分析。这对于企业用户和注重隐私的个人来说至关重要,尤其是在处理敏感业务信息时。

通过本地部署,你可以完全绕过网络限制,直接在国内环境使用各种AI模型的能力。配合可靠的API中转服务(如laozhang.ai),即使在不具备海外网络条件的环境中,也能流畅地使用OpenAI、Claude等模型的强大功能。

LobeChat提供了丰富的定制选项,你可以根据自己的需求进行各种调整:从主题外观、语言设置、到模型参数、插件系统,甚至是底层数据库,都可以完全按照个人或团队需求进行配置,打造真正专属的AI助手。

一个突出优势是LobeChat支持多种模型接入方式。你可以同时连接OpenAI、Anthropic Claude、Google Gemini等云端模型,也可以通过Ollama集成本地部署的开源模型如Llama 3、DeepSeek、Qwen等,真正实现"一个界面,多种能力"。

对于长期使用AI的用户来说,本地部署可以显著降低成本。通过API中转服务如laozhang.ai,你可以享受到比官方更优惠的价格;结合本地开源模型,更多场景甚至可以完全免费使用,大幅降低AI使用门槛和成本。

根据不同用户的技术水平和需求,我们将LobeChat的部署方式分为三个梯度:入门级、进阶级和专业级。下面是各种部署方式的详细对比:

接下来,我们将详细介绍几种最常用部署方式的具体操作步骤。每种方法都经过实测,确保2025年仍然有效可行。

这是最简单易行的方法,适合绝大多数用户,只需几行命令即可完成:

确保已安装Docker(如未安装,访问Docker官网下载安装)

打开终端(Windows用PowerShell或CMD,Mac/Linux用Terminal),运行以下命令拉取LobeChat镜像:

docker pull lobehub/lobe-chat

docker run -d -p 8080:3000 -e OPENAI_API_KEY=sk-your_key_here -e ACCESS_CODE=your_password lobehub/lobe-chat

? 专业提示:如果你没有OpenAI的API密钥,可以使用laozhang.ai的中转服务,只需将上面的OPENAI_API_KEY替换为你在laozhang.ai注册获得的API密钥,同时添加

-e OPENAI_API_BASE_URL=https://api.laozhang.ai/v1参数即可。

对于需要更稳定和功能完善的部署,推荐使用Docker Compose方式,这样可以配置持久化存储和多种环境变量:

docker-compose.yml的文件,内容如下:version: '3'

services:

lobe-chat:

image: lobehub/lobe-chat:latest

container_name: lobe-chat

restart: always

ports:

- "8080:3000"

environment:

# 替换为你的API密钥或中转服务

- OPENAI_API_KEY=sk-your_key_here

# 可选:使用中转服务的API地址

- OPENAI_API_BASE_URL=https://api.laozhang.ai/v1

# 访问密码保护,防止他人未经授权访问

- ACCESS_CODE=your_password_here

# 允许上传文件功能

- ENABLE_FILE_UPLOAD=1

volumes:

# 数据持久化存储

- ./data:/app/data

docker-compose up -d

⚠️ 重要提示:为保护你的API密钥安全,强烈建议设置ACCESS_CODE访问密码,防止他人未经授权使用你的部署实例和API额度。

想要完全离线使用,或者希望尝试开源模型,可以通过以下步骤集成Ollama:

首先安装并启动Ollama(访问Ollama官网下载)

拉取你想使用的模型,例如Llama 3:

ollama pull llama3

docker run -d -p 8080:3000 --network=host -e OLLAMA_API_BASE_URL=http://127.0.0.1:11434/api lobehub/lobe-chat

部署完成后,如果希望在外出时通过手机访问家中或办公室部署的LobeChat,可以通过内网穿透实现:

# Linux/Mac安装

curl -L https://cpolar.com/static/downloads/install-release-cpolar.sh | sudo bash

# 或Windows下载安装包:https://www.cpolar.com/download

cpolar login

cpolar http 8080

? 安全提示:使用内网穿透时,务必在LobeChat中设置ACCESS_CODE访问密码,避免他人未经授权访问你的服务和API密钥!

部署完成后,我们还需要进行一些配置,以充分发挥LobeChat的潜力:

LobeChat最强大的功能之一是支持多种AI模型,但你需要提供对应的API密钥。以下是几种常用模型的配置方法:

如果你有OpenAI官方API密钥,可以直接配置环境变量:

-e OPENAI_API_KEY=sk-your_key_here

如果你在国内无法直接访问OpenAI API,或者希望降低使用成本,可以使用中转服务,例如laozhang.ai:

-e OPENAI_API_KEY=sk-your_laozhang_key

-e OPENAI_API_BASE_URL=https://api.laozhang.ai/v1

? laozhang.ai提供稳定的API中转服务,成本比OpenAI官方低约40%,并提供免费额度。点此注册即可获得免费测试额度。

Claude系列模型在某些场景下表现优秀,配置方法:

-e CLAUDE_API_KEY=sk-ant-your_key_here

同样,你也可以使用laozhang.ai的Claude API中转服务:

-e CLAUDE_API_KEY=sk-your_laozhang_key

-e CLAUDE_API_BASE_URL=https://api.laozhang.ai/v1

在实际使用中,你可能希望同时使用多种模型,以下是Docker Compose配置示例:

environment:

# OpenAI配置

- OPENAI_API_KEY=sk-your_key

- OPENAI_API_BASE_URL=https://api.laozhang.ai/v1

# Claude配置

- CLAUDE_API_KEY=sk-your_key

- CLAUDE_API_BASE_URL=https://api.laozhang.ai/v1

# Google Gemini配置

- GEMINI_API_KEY=your_key

除了API配置,还有一些重要设置可以提升使用体验:

设置访问密码:保护你的部署实例

-e ACCESS_CODE=your_password

启用文件上传:支持上传图片、文档等

-e ENABLE_FILE_UPLOAD=1

配置知识库功能:需要设置向量数据库

-e ENABLE_KNOWLEDGE=1

-e VECTOR_EMBED_MODEL=text-embedding-ada-002

多用户模式:适合团队使用

-e DEFAULT_USER_ROLE=user

-e NEXT_PUBLIC_ENABLE_MULTI_USER=1

在部署和使用过程中,你可能会遇到一些问题,这里是最常见问题的解答:

A1: 这通常是因为网络限制导致无法直接访问OpenAI API。建议使用API中转服务如laozhang.ai,只需添加环境变量OPENAI_API_BASE_URL=https://api.laozhang.ai/v1并使用laozhang.ai提供的API密钥即可解决。

A2: 配置多个模型的API密钥后,在创建新对话时,点击左上角的模型选择下拉菜单,即可选择已配置的任何模型。不同对话可以使用不同模型,非常灵活。

A3: 使用以下命令拉取最新镜像并重启容器:

docker pull lobehub/lobe-chat:latest

docker stop lobe-chat

docker rm lobe-chat

# 然后重新运行启动命令

如果使用Docker Compose,只需运行docker-compose pull然后docker-compose up -d即可。

A4: 数据库版部署后,首位注册用户自动成为管理员。管理员可以在"设置→用户管理"中添加、删除用户账号和设置权限。每个用户都有独立的对话历史和设置。

A5: 这取决于你的需求:

A6: 根据你的部署方式不同:

/app/data目录(如果使用Docker卷挂载)通过本文介绍的多种部署方案,你应该能够根据自己的技术水平和需求,选择最适合的LobeChat部署方式。总结一下关键要点:

? 最后提示:如果你主要关注使用体验而非完全控制权,可以考虑使用现成的API中转服务。laozhang.ai不仅提供OpenAI和Claude的API中转,还有丰富的免费额度和技术支持,是LobeChat配置的理想搭配!

Github地址:https://github.com/lobehub

隨著夏天的尾聲,LobeChat 也步入了其 1.0 版本後的重要里程碑 —— 文件上傳 與 知識庫 功能正式推出!

自從 LobeChat 開源以來,文件上傳和知識庫就是社區期待已久的功能。自 1.0 版本發布以來,我們的討論區和問題反饋中,大約有十分之一是關於這兩項功能的討論和請求。知識庫顯然成為了目前呼聲最高的特性需求。

因此,在發布伺服器端資料庫方案之後,我們立即開始著手開發文件上傳和知識庫功能。經過近兩個月的精心設計和開發,我們非常高興地宣布:LobeChat 知識庫現已在 開源版 和 Cloud 版 中正式上線!

文件上傳與知識庫管理

比起很多同類產品,我們在側邊欄添加入口這件事上非常克制。但是在這次需求中我們認為文件上傳和知識庫管理是一個非常重要的一级功能。因此,我們在 LobeChat 的左側邊欄新增了一個醒目的「文件」入口。通過這個新入口,你可以輕鬆訪問和管理存儲在 LobeChat 中的各種文件。

支持全類型文件存儲

LobeChat 現支持所有類型的文件上傳,無論是文檔、圖片、音頻還是視頻文件,都可以輕鬆上傳並存儲。你甚至可以將其作為一個不帶文件夾功能的簡易網盤來使用。

同時,為了保證在文件管理過程中的基本使用體驗,我們提供了多選、批量刪除和複製鏈接等基礎文件操作功能,旨在簡化文件管理任務,幫你高效地處理大量文件。

多種常見文件格式在線預覽

目前支持如 PDF、Excel、Word、PPT 和 TXT 等多種常見文件格式的在線預覽。無需離開 LobeChat 界面,就可以直接查看和審閱文件內容。

市面上的文件格式千千萬萬,我們深知個人的力量是無法適配所有文件的預覽,因此我們非常期望和社區一起共建這項特性。基於開源解決方案,我們開發了一個可擴展的文件預覽組件,文件預覽功能不僅限於當前支持的格式,可以輕鬆地擴展支持更多的文件類型。

如果 LobeChat 現有的預覽功能不滿足你的訴求,希望支持更多文件格式的預覽,您可以通過提交 PR (參考示例)或在 討論區 提出需求,我們將根據需求逐步實現。

知識庫管理

在界面的左側菜單中,我們設計了一個清晰可見的知識庫管理列表,展示了所有已創建的知識庫。無論是開源版本還是 Cloud 版本,LobeChat 都允許你創建 無限數量 的知識庫。

目前一期的知識庫中暫時支持文件管理,未來我們會提供召回測試、Benchmark 測試、查詢配置等更多進階功能。

文件分塊與向量化

一鍵分塊與向量化

要說我們的知識庫和雲端硬碟的最大區別,就在於我們支持對不同類型文件的「分塊與向量化」。

分塊相當於將文件按照特定結構拆分為文本片段(Chunk),而向量化則是將這些對應的文本片段轉換為一串 [0.19,0.34,...] 這樣的向量,在後續檢索中用於語義化匹配查詢。

正是分塊與向量化的這個環節,才區別於傳統雲端硬碟,讓我們真正實現文件 / 知識庫對話。

分塊詳情預覽

同時在完成向量化後,我們還支持了向量化後的片段預覽,點擊分開即可查看分塊詳情。

此外,我們也在實現初期探索了基於 Unstructed.io 的 PDF 分塊方案,結合 Unstructed 分塊的元信息,我們甚至可以在 hover 某個 chunk 時,直接將 PDF 內其對應的文本區域高亮顯示。這個能力也會在後續迭代中和大家見面。

分塊類型擴展

目前知識庫一期並不支持語音、圖片、視頻的向量化,但我們的架構設計已為支持這些文件的擴展做了鋪墊。只要新增一個分塊類型,我們就能實現對一類文件的語義檢索和對話。比如後續計劃支持的文件類型有:

MP3 等音頻文件:通過 whisper-1 這樣的 stt 模型轉成文本,然後即可採用純文本方式實現後續的切塊與向量化;

圖片文件:通過 gpt-4o/sonnet 等支持 vision 的模型來完整描述圖片的內容,並保存為純文本,進而實現後續的切塊與向量化;

視頻文件:簡化版的做法是提取音頻後走音頻文件的處理鏈路,但這樣會丟失畫面信息,更理想的是使用視頻理解模型做內容提取,再走文本切塊方案;

和文件預覽一樣,我們深知單憑我們是不可能完成對所有文件類型的分塊方案的,因此我們也希望能和社區一起共建分塊類型的擴展,逐步擴展知識庫對話的邊界。

知識庫對話

最後我們再來看下最為核心的知識庫對話功能。

對話中直接上傳

我們認識到,大多數用戶傾向於在對話框中上傳文件。因此,我們對文件上傳的交互設計進行了優化,增強了文件上傳的預覽與進度顯示功能,使用戶能夠在上傳過程中獲得更清晰的反饋和更好的體驗。

在文件上傳完成後,系統會自動進行文件分塊和向量化處理。這一過程是無縫的,處理完成後,您可以立即開始與文件進行對話,實現文件內容的深入探索和信息檢索。

文件預覽與召回塊分析

在前段時間我們預告了 Portal 交互的意義,而在文件對話這個場景下也能非常好地結合在一起。你可以通過點擊文件直接在 Portal 中打開並預覽文件。復對話的窗口提供了一個直觀的界面,使得你可以在其中查看文件內容和與本次對話相關的文本塊。

點擊任何一個文本塊,你就可以在 Portal 中查看到文本塊的內容。這一功能對於做檢索分析來說可以說非常方便。

關聯文件 / 知識庫對話

在設計知識庫對話功能時,我們確保其與插件的使用邏輯一致。你可以輕鬆地將選定的知識庫或文件添加到對話助手中。此外,還可以根據需要選擇激活或關閉特定的知識庫或文件。

這種設計不僅提供了操作上的靈活性,也允許根據具體的應用場景切換不同的知識庫。

總結

和很多 AI 對話產品做文件上傳的思路不一樣,我們做這個功能的出發源點更像是「知識管理」。因此我們在功能的設計中非常關注內容的可沉澱性。甚至在未來,我們還會基於現有的能力框架,讓你之前的對話都可以被記憶和檢索,進而 “增援未來”。這也是我們標題所說的「跬步千里」之意。

以上便是 LobeChat 中的知識庫功能,希望你能喜歡。

「梦想一旦被付诸行动,就会变得神圣,如果觉得我的文章对您有用,请帮助本站成长」

上一篇:Gmail 铁律被打破:谷歌账号名(前缀)终于可以改了!

下一篇:数十位评审专家姓名疑似照搬网络人名,湖北竹溪一些政府采购项目涉嫌造假

从有人以来就没有比张麻子更邪恶 张口闭口为人民,害死几千万人还为人民,为自己的皇位还差不多,...

评:深度解析《让子弹飞》求科学离线插件,谢谢!34401355@qq.com

评:改版梅林固件安装SS【shadowsocks】科学上网插件教程求科学离线插件,谢谢!!!

评:改版梅林固件安装SS【shadowsocks】科学上网插件教程